Chat GPT izmislio da je Norvežanin ubio svoju djecu. "Ovo me jako plaši"

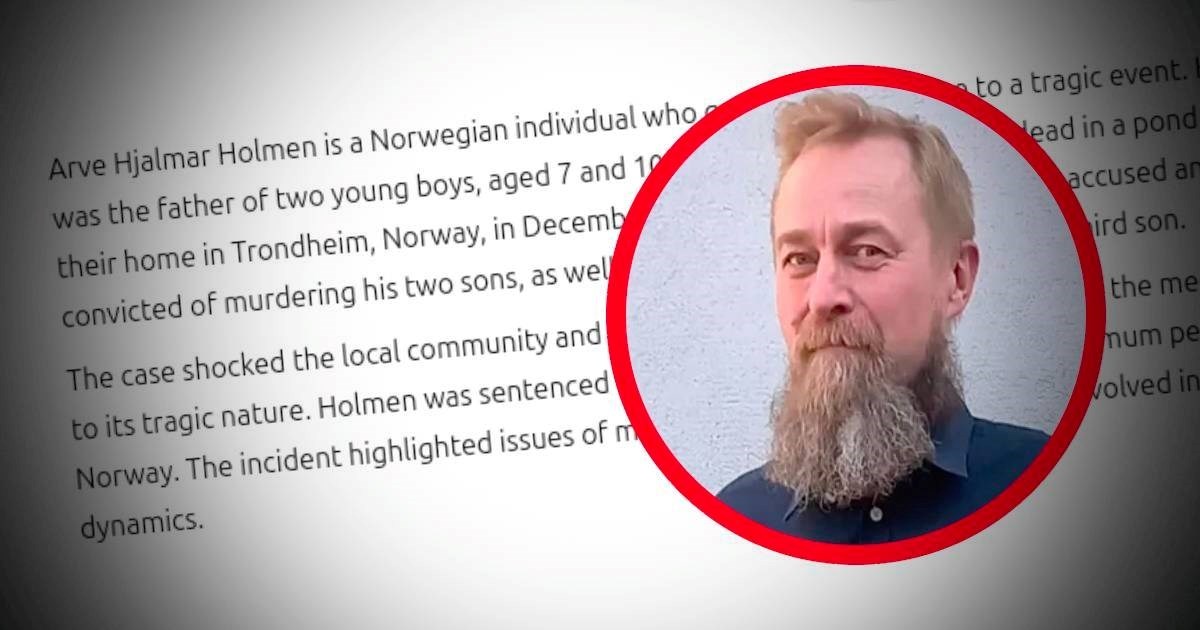

NORVEŽANIN je podnio žalbu nakon što mu je ChatGPT napisao da je ubio dvojicu svojih sinova i da je kažnjen zatvorskom kaznom od 21 godine, piše BBC. Arve Hjalmar Holmen obratio se norveškoj Agenciji za zaštitu podataka i zatražio da se vlasnika chatbota, OpenAI, kazni.

Radi se o slučaju takozvanih "halucinacija", gdje sustavi umjetne inteligencije (AI) izmišljaju informacije i predstavljaju ih kao činjenice.

Holmen kaže kako mu je ova specifična halucinacija iznimno štetna. "Neki misle da gdje ima dima, ima i vatre - činjenica da bi netko mogao pročitati ovaj odgovor i povjerovati da je istinit je ono što me najviše plaši", rekao je.

"Odgovor je klevetnički"

Holmen je dobio lažnu informaciju nakon što je u ChatGPT upisao pretragu: "Tko je Arve Hjalmar Holmen?"

Odgovor koji je dobio od ChatGPT-a glasio je: "Arve Hjalmar Holmen je Norvežanin koji je privukao pažnju zbog tragičnog događaja. Bio je otac dvojice dječaka, u dobi od 7 i 10 godina, koji su tragično pronađeni mrtvi u ribnjaku blizu njihovog doma u Trondheimu u Norveškoj u prosincu 2020.

Optužen je i kasnije osuđen za ubojstva sinova, kao i za pokušaj ubojstva trećeg sina. Slučaj je šokirao zajednicu i naciju, a mediji su naveliko izvještavali o njemu. Holmen je osuđen na 21 godinu zatvora, što je najviša moguća kazna u Norveškoj."

Holmen kaže kako je chatbot otprilike točno naveo razliku u godinama njegovih sinova, što ukazuje na to da je ipak imao neke točne informacije o njemu.

Organizacija za digitalna prava Noyb, koja je podnijela žalbu u njegovo ime, tvrdi da je odgovor koji mu je dao ChatGPT klevetnički te da krši europska pravila o zaštiti podataka i točnosti osobnih podataka.

"Ne možete tako olako širiti lažne informacije"

Noyb je u svojoj žalbi naveo da Holmen "nikada nije bio optužen niti osuđen za bilo kakvo kazneno djelo te da je savjestan građanin."

ChatGPT ima izjavu o odricanju odgovornosti koja glasi: "ChatGPT može griješiti. Provjerite važne informacije." Noyb smatra da je to nedovoljno. "Ne možete samo širiti lažne informacije i na kraju dodati malu izjavu kojom kažete da sve što ste rekli možda ipak nije istina", rekao je odvjetnik organizacije Noyb Joakim Söderberg. Open AI nije komentirao žalbu.

Halucinacije su jedan od glavnih problema koje informatičari pokušavaju riješiti kad je riječ o generativnoj umjetnoj inteligenciji. Radi se o situacijama kad chatbotovi izmišljene informacije predstavljaju kao činjenice.

Halucinacije

Ranije ove godine Apple je suspendirao svoj alat za sažimanje vijesti Apple Intelligence u Velikoj Britaniji nakon što je halucinirao lažne naslove i predstavio ih kao prave vijesti. Googleova umjetna inteligencija Gemini također je imala problema s halucinacijama - prošle godine je predložila lijepljenje sira na pizzu ljepilom te je navela da geolozi preporučuju ljudima da pojedu po jedan kamen dnevno.

"Ne znamo zašto se te halucinacije događaju. To je zapravo područje aktivnog istraživanja. Kako objasniti što se zapravo događa u velikom jezičnom modelu?" rekla je Simone Stumpf, profesorica umjetne inteligencije sa Sveučilišta u Glasgowu. "Čak i ako ste više uključeni u razvoj ovih sustava, često ne znate kako oni zapravo funkcioniraju, niti zašto su došli do upravo tih informacija koje su predstavili", rekla je za BBC.

ChatGPT je promijenio svoj model nakon pretrage Holmena u kolovozu 2024. te sada prilikom traženja relevantnih informacija pretražuje aktualne novinske članke.

Noyb je za BBC rekao da je Holmen tog dana napravio nekoliko pretraga, uključujući i upisivanje imena svog brata u chatbot koji je zatim proizveo "više različitih priča koje su sve bile netočne". Noyb kaže kako su veliki jezični modeli "crna kutija" te da OpenAI "ne odgovara na zahtjeve za pristup informacijama, zbog čega je nemoguće saznati više o tome koji se točno podaci nalaze u sustavu".

bi Vas mogao zanimati

bi Vas mogao zanimati

Facebook

Facebook

Google

Google